マスクされた言語モデルは、自然言語理解 (NLU) におけるより困難なタスクのいくつかを解決するために使用される自然言語処理 (NLP) アルゴリズムの一種です。典型的なマスク言語モデルでは、特定の言語の単語は「マスク」または「隠蔽」されており、モデルは元の単語を推測するために「空白を埋める」必要があります。これにより、単語の背後にある意味を理解するモデルの能力が強化され、新しいデータの予測を生成したり、推論タスクに使用したりできます。

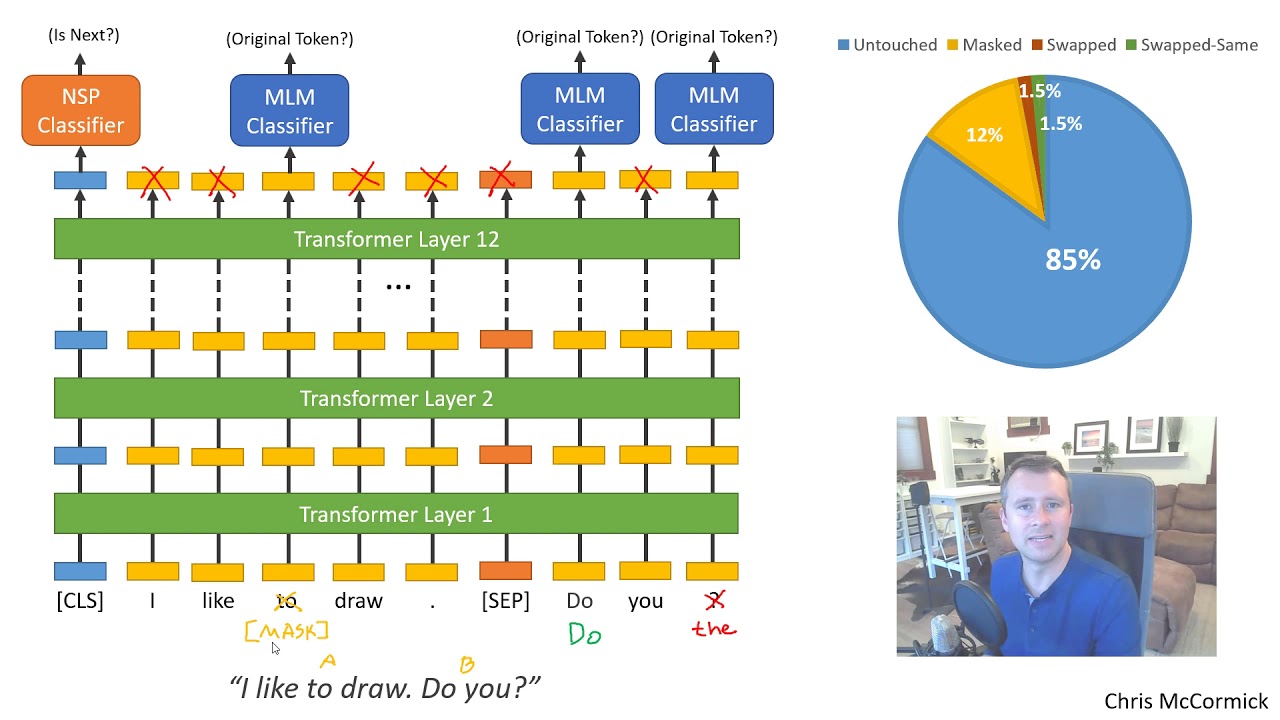

マスクされた言語モデルの使用は 2000 年代半ばに始まり、質問応答、要約、感情分析などのアプリケーションで人気が高まりました。最も人気のあるマスク言語モデルは、2018 年に Google によってリリースされた BERT (Bidirectional Encoder Representations from Transformers) です。BERT は、多数の双方向「トランスフォーマー ブロック」を使用して、ラベルのないテキストから言語表現を学習できる深層学習ベースの手法です。 」これにより、特定の言語モデルの重みが最適化され、自然言語理解タスクのパフォーマンスが向上します。

マスクされた言語モデルは、複雑なテキストの理解と生成を必要とする産業レベルのプロジェクトでも使用されています。たとえば、このテクノロジーは、より正確な顧客サービス チャットボットやパーソナライズされた推奨事項に適用されています。

このテクノロジーはまだ初期段階にありますが、急速に成長しています。より多くのデータが利用可能になり、これらのモデルの精度が向上し続けるにつれて、マスクされた言語モデルは自然言語処理の将来に大きな影響を与えると予想されます。