ลองนึกภาพตัวเองเป็นนักสำรวจที่ชอบผจญภัย มุ่งหน้าสู่ดินแดนอันกว้างใหญ่และลึกลับของอเมซอน ไม่ใช่ป่าฝน แต่เป็นร้านค้าปลีกออนไลน์ยักษ์ใหญ่ ทุกการคลิก คุณจะค้นพบสมบัติล้ำค่า เจาะลึกเข้าไปในขอบเขตของข้อมูลที่ไม่เคยมีมาก่อน

ในการเดินทางที่น่าตื่นเต้นนี้ เรานำเสนอคำแนะนำทีละขั้นตอนเพื่อสำรวจป่าดิจิทัลที่หนาแน่นของการขูดเว็บของ Amazon เตรียมออกเดินทางสู่การเดินทางที่ไม่เหมือนใคร พร้อมด้วยคำแนะนำและเคล็ดลับจากผู้เชี่ยวชาญเพื่อดึงข้อมูลอันมีค่าด้วยความแม่นยำที่ไม่มีใครเทียบได้

สารบัญ

- ข้อมูลใดที่จะขูดจาก Amazon

- ข้อกำหนดพื้นฐานบางประการ

- การตั้งค่าสำหรับการขูด

- การขูดข้อมูลผลิตภัณฑ์ของ Amazon

- วิธีขูดหลายหน้าใน Amazon

- การขูด Amazon: คำถามที่พบบ่อย

- บทสรุป

ดังนั้น รวบรวมความกล้า สวมรองเท้าบู๊ตเสมือนจริง แล้วมาเริ่มต้นการผจญภัยที่ขับเคลื่อนด้วยข้อมูลด้วยกัน!

ข้อมูลใดที่จะขูดจาก Amazon

มีจุดข้อมูลมากมายที่เกี่ยวข้องกับผลิตภัณฑ์ของ Amazon แต่องค์ประกอบสำคัญที่ต้องให้ความสำคัญเมื่อทำการขูด ได้แก่:

- ชื่อผลิตภัณฑ์

- ค่าใช้จ่าย

- ออมทรัพย์ (ถ้ามี)

- สรุปรายการ

- รายการคุณสมบัติที่เกี่ยวข้อง (ถ้ามี)

- คะแนนรีวิว

- ภาพผลิตภัณฑ์

แม้ว่าสิ่งเหล่านี้จะเป็นประเด็นหลักที่ต้องพิจารณาเมื่อคัดแยกสินค้าจาก Amazon แต่สิ่งสำคัญที่ควรทราบคือข้อมูลที่คุณดึงออกมาอาจแตกต่างกันไปขึ้นอยู่กับวัตถุประสงค์เฉพาะของคุณ

ข้อกำหนดพื้นฐานบางประการ

ในการเตรียมซุป เราจำเป็นต้องมีส่วนผสมที่เหมาะสม ในทำนองเดียวกัน web scraper ใหม่ของเราต้องการส่วนประกอบเฉพาะ

- หลาม — คอลเลกชั่นไลบรารี่ที่ใช้งานง่ายและกว้างขวางทำให้ Python เป็นตัวเลือกอันดับต้น ๆ สำหรับการขูดเว็บ หากยังไม่ได้ติดตั้ง โปรดดูคำแนะนำนี้

- BeautifulSoup — นี่เป็นหนึ่งในไลบรารี่การขูดเว็บจำนวนมากสำหรับ Python ความเรียบง่ายและการใช้งานที่สะอาดตาทำให้เป็นตัวเลือกยอดนิยมสำหรับการขูดเว็บ หลังจากติดตั้ง Python สำเร็จแล้ว คุณสามารถติดตั้ง Beautiful Soup ได้โดยการรัน: pip install bs4

- ความเข้าใจพื้นฐานเกี่ยวกับแท็ก HTML — ศึกษาบทช่วยสอนนี้เพื่อรับความรู้ที่จำเป็นเกี่ยวกับแท็ก HTML

- เว็บเบราว์เซอร์ — เนื่องจากเราจำเป็นต้องกรองข้อมูลที่ไม่เกี่ยวข้องจำนวนมากออกจากเว็บไซต์ จึงจำเป็นต้องมีรหัสและแท็กเฉพาะเพื่อวัตถุประสงค์ในการกรอง เว็บเบราว์เซอร์เช่น Google Chrome หรือ Mozilla Firefox มีประโยชน์ในการระบุแท็กเหล่านั้น

การตั้งค่าสำหรับการขูด

ในการเริ่มต้น ตรวจสอบให้แน่ใจว่าคุณได้ติดตั้ง Python แล้ว หากคุณไม่มี Python 3.8 หรือใหม่กว่า โปรดไปที่ python.org เพื่อดาวน์โหลดและติดตั้งเวอร์ชันล่าสุด

จากนั้น สร้างไดเร็กทอรีเพื่อจัดเก็บไฟล์โค้ดขูดเว็บสำหรับ Amazon โดยทั่วไปเป็นความคิดที่ดีที่จะตั้งค่าสภาพแวดล้อมเสมือนจริงสำหรับโปรเจ็กต์ของคุณ

ใช้คำสั่งต่อไปนี้เพื่อสร้างและเปิดใช้งานสภาพแวดล้อมเสมือนบน macOS และ Linux:

$ python3 -m venv .env

$ source .env/bin/activateสำหรับผู้ใช้ Windows คำสั่งจะแตกต่างออกไปเล็กน้อย:

d:amazon>python -m venv .env

d:amazon>.envscriptsactivateถึงเวลาติดตั้งแพ็คเกจ Python ที่จำเป็นแล้ว

คุณจะต้องมีแพ็คเกจสำหรับสองงานหลัก: การรับ HTML และการแยกวิเคราะห์เพื่อแยกข้อมูลที่เกี่ยวข้อง

ไลบรารีคำขอเป็นไลบรารี Python บุคคลที่สามที่ใช้กันอย่างแพร่หลายสำหรับการส่งคำขอ HTTP มีอินเทอร์เฟซที่ตรงไปตรงมาและใช้งานง่ายสำหรับส่งคำขอ HTTP ไปยังเว็บเซิร์ฟเวอร์และรับการตอบกลับ อาจเป็นไลบรารี่ที่มีชื่อเสียงที่สุดสำหรับการขูดเว็บ

อย่างไรก็ตาม ไลบรารีคำขอมีข้อจำกัด: โดยจะส่งคืนการตอบสนอง HTML เป็นสตริง ซึ่งอาจเป็นเรื่องยากในการค้นหาองค์ประกอบเฉพาะ เช่น รายการราคา เมื่อเขียนโค้ดขูดเว็บ

นั่นคือที่มาของ Beautiful Soup Beautiful Soup เป็นไลบรารี Python ที่ออกแบบมาสำหรับการคัดลอกเว็บที่ดึงข้อมูลจากไฟล์ HTML และ XML ช่วยให้คุณสามารถดึงข้อมูลจากหน้าเว็บโดยการค้นหาแท็ก คุณลักษณะ หรือข้อความเฉพาะ

หากต้องการติดตั้งทั้งสองไลบรารี ให้ใช้คำสั่งต่อไปนี้:

$ python3 -m pip install requests beautifulsoup4สำหรับผู้ใช้ Windows ให้แทนที่ 'python3' ด้วย 'python' โดยคงคำสั่งที่เหลือไว้เหมือนเดิม:

d:amazon>python -m pip install requests beautifulsoup4โปรดทราบว่าเรากำลังติดตั้งไลบรารี Beautiful Soup เวอร์ชัน 4

ตอนนี้เรามาทดสอบไลบรารี่การขูดคำขอ สร้างไฟล์ใหม่ชื่อ amazon.py และป้อนรหัสต่อไปนี้:

import requests

url = 'https://www.amazon.com/Bose-QuietComfort-45-Bluetooth-Canceling-Headphones/dp/B098FKXT8L'

response = requests.get(url)

print(response.text)บันทึกไฟล์และเรียกใช้จากเทอร์มินัล

$ python3 amazon.pyในกรณีส่วนใหญ่ คุณจะไม่สามารถดู HTML ที่ต้องการได้ Amazon จะบล็อกคำขอ และคุณจะได้รับคำตอบต่อไปนี้:

To discuss automated access to Amazon data please contact [email protected].หากคุณพิมพ์ response.status_code คุณจะเห็นว่าคุณได้รับข้อผิดพลาด 503 แทนที่จะเป็นรหัสสำเร็จ 200

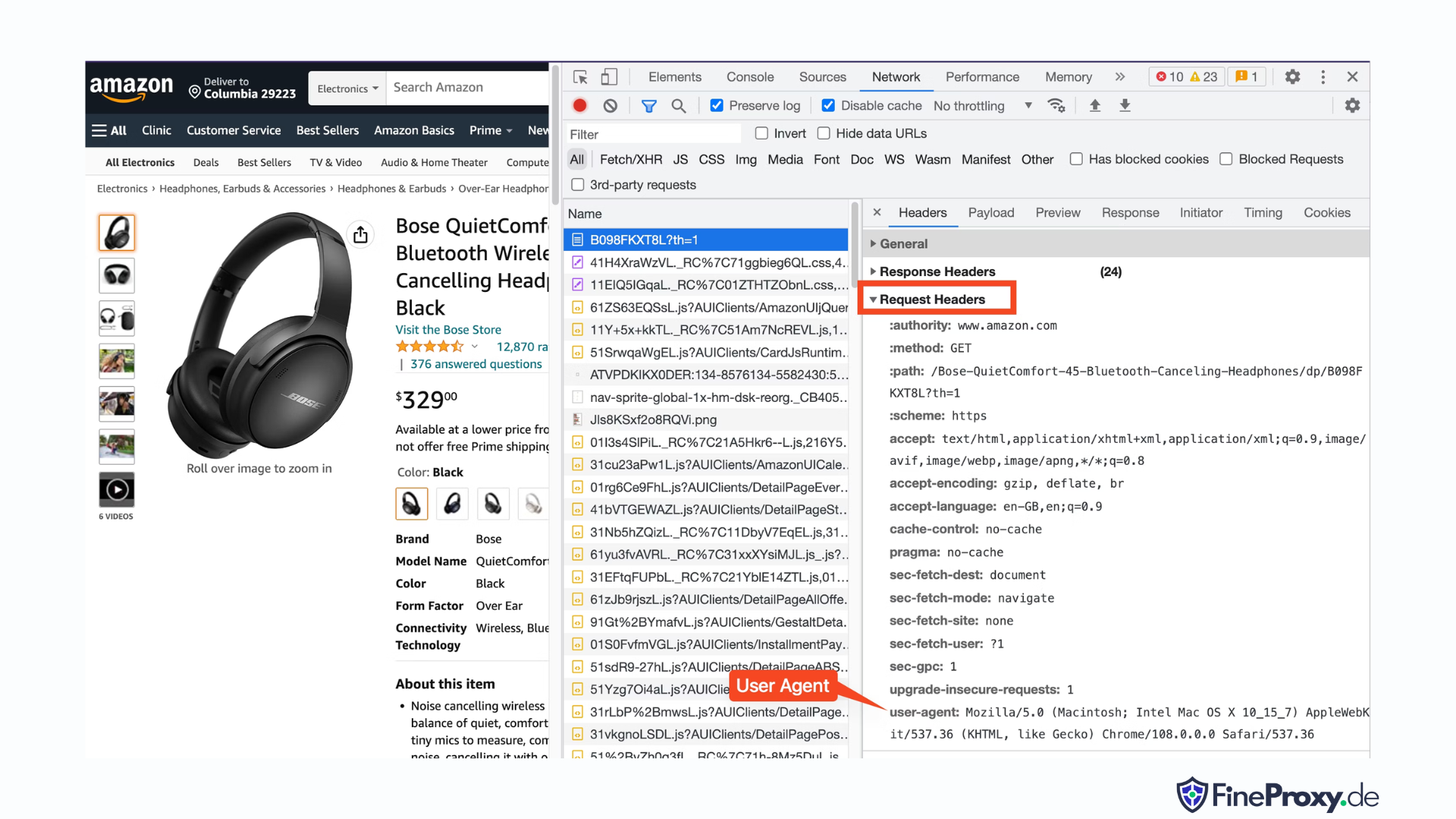

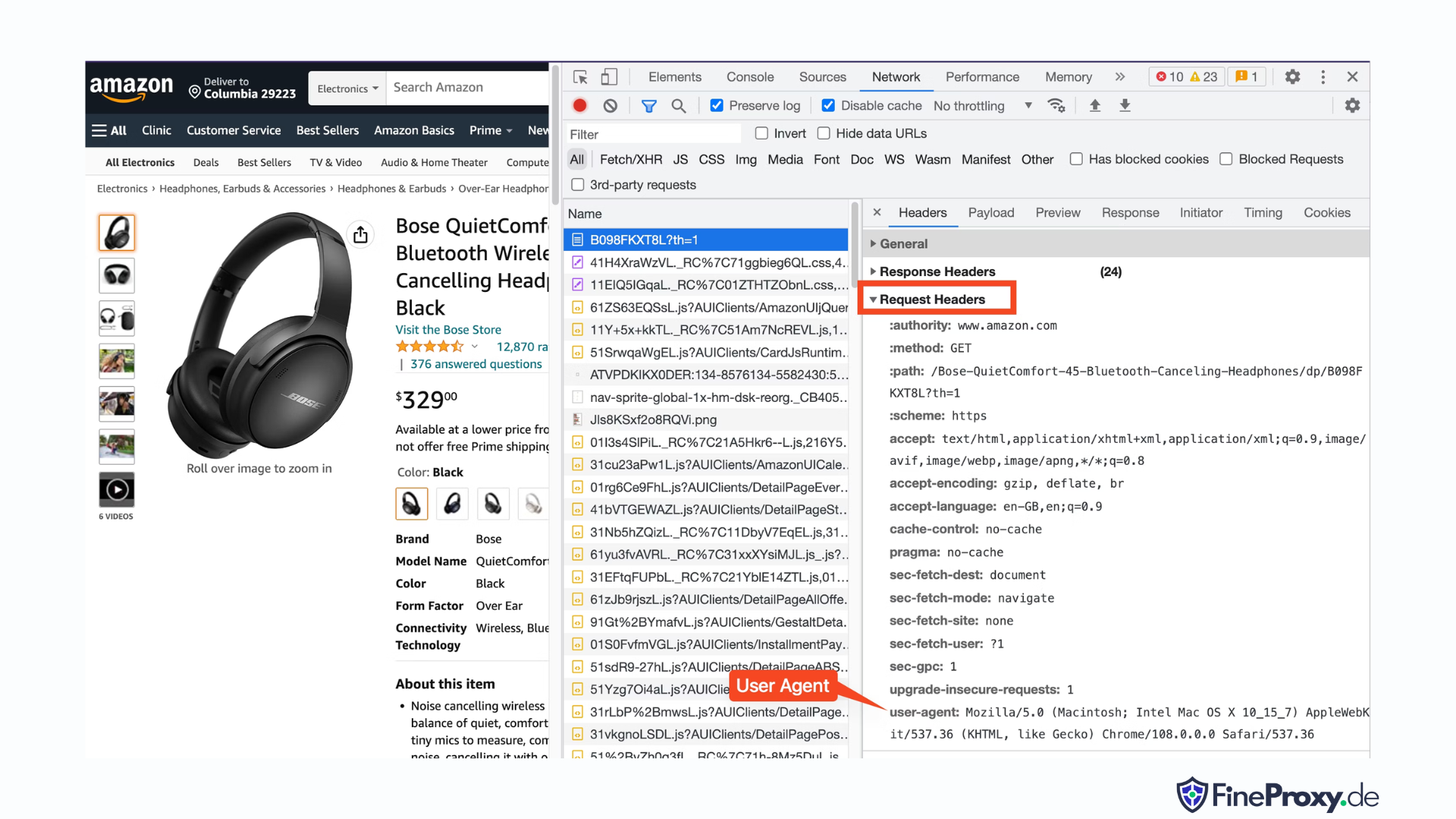

Amazon รู้ว่าคำขอนี้ไม่ได้มาจากเบราว์เซอร์และบล็อกคำขอดังกล่าว แนวทางปฏิบัตินี้เป็นเรื่องปกติในหลายเว็บไซต์ Amazon อาจบล็อกคำขอของคุณและส่งคืนรหัสข้อผิดพลาดที่ขึ้นต้นด้วย 500 หรือบางครั้งอาจเป็น 400

วิธีแก้ไขง่ายๆ คือส่งส่วนหัวพร้อมกับคำขอของคุณที่เลียนแบบส่วนหัวที่ส่งโดยเบราว์เซอร์

บางครั้งการส่งเฉพาะ user-agent ก็เพียงพอแล้ว ในบางครั้ง คุณอาจต้องส่งส่วนหัวเพิ่มเติม เช่น ส่วนหัวที่ยอมรับภาษา

หากต้องการค้นหา user-agent ที่เบราว์เซอร์ของคุณส่งมา ให้กด F12 เปิดแท็บเครือข่าย แล้วโหลดหน้านี้ซ้ำ เลือกคำขอแรกและตรวจสอบส่วนหัวของคำขอ

คัดลอก user-agent นี้และสร้างพจนานุกรมสำหรับส่วนหัว เช่นเดียวกับตัวอย่างนี้ที่มีส่วนหัว user-agent และ Accept-Language:

custom_headers = { '

user-agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/108.0.0.0 Safari/537.36',

'accept-language': 'en-GB,en;q=0.9',

}จากนั้นคุณสามารถส่งพจนานุกรมนี้เป็นพารามิเตอร์ทางเลือกในเมธอด get ได้:

response = requests.get(url, headers=custom_headersการขูดข้อมูลผลิตภัณฑ์ของ Amazon

ในกระบวนการขูดเว็บผลิตภัณฑ์ของ Amazon โดยทั่วไปคุณจะมีส่วนร่วมกับหน้าสองประเภท: หน้าหมวดหมู่และหน้ารายละเอียดสินค้า

เช่น เยี่ยมชม https://www.amazon.com/b?node=12097479011 หรือค้นหาหูฟังแบบครอบหูใน Amazon หน้าที่แสดงผลการค้นหาเรียกว่าหน้าหมวดหมู่

หน้าหมวดหมู่จะแสดงชื่อผลิตภัณฑ์ รูปภาพผลิตภัณฑ์ การให้คะแนนผลิตภัณฑ์ ราคาผลิตภัณฑ์ และที่สำคัญที่สุดคือหน้า URL ของผลิตภัณฑ์ หากต้องการเข้าถึงข้อมูลเพิ่มเติม เช่น รายละเอียดสินค้า คุณต้องไปที่หน้ารายละเอียดสินค้า

มาวิเคราะห์โครงสร้างของหน้ารายละเอียดสินค้ากันดีกว่า

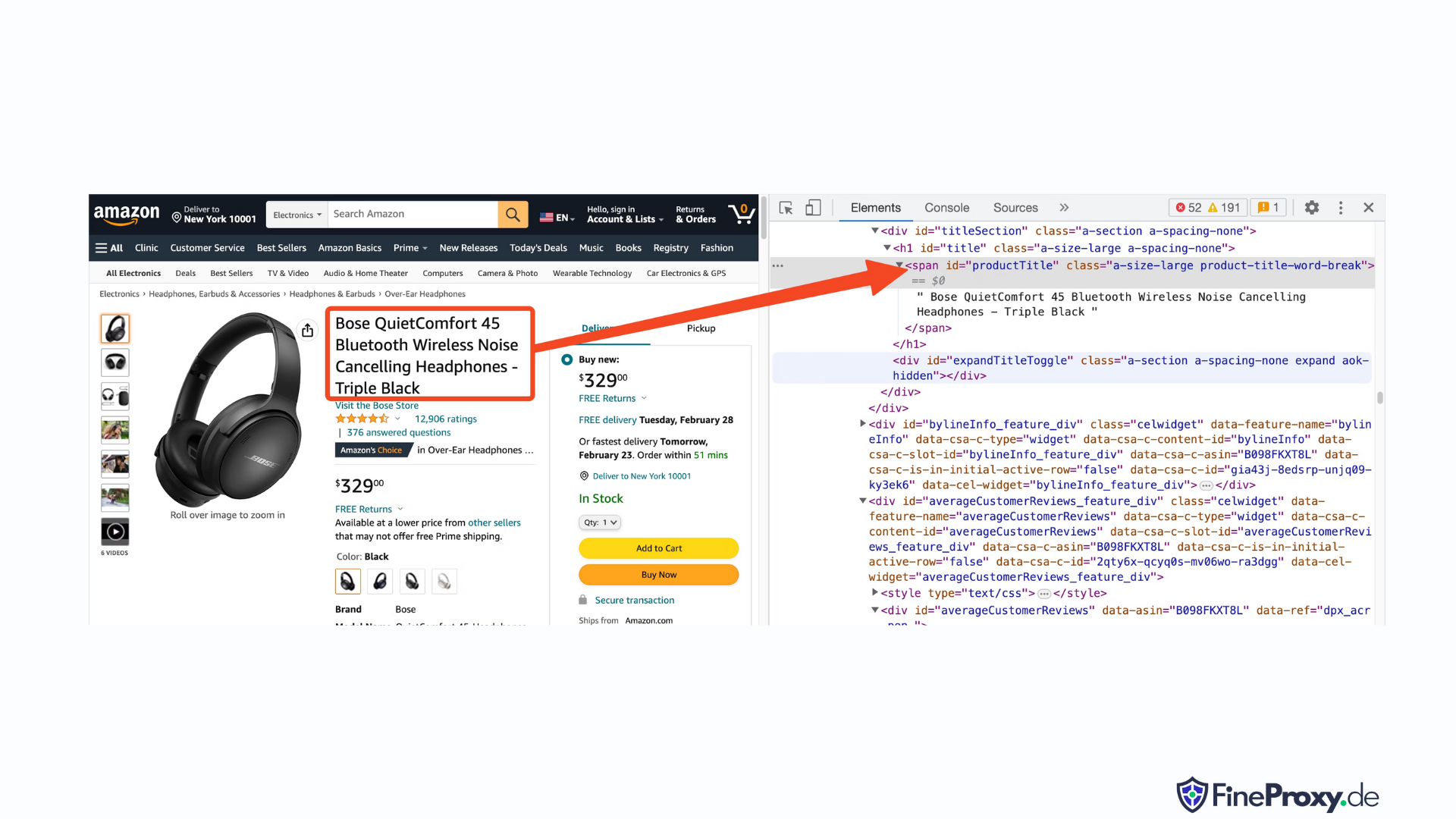

เปิด URL สินค้า เช่น https://www.amazon.com/Bose-QuietComfort-45-Bluetooth-Canceling-Headphones/dp/B098FKXT8Lโดยใช้ Chrome หรือเบราว์เซอร์สมัยใหม่อื่น ๆ คลิกขวาที่ชื่อผลิตภัณฑ์แล้วเลือกตรวจสอบ มาร์กอัป HTML ของชื่อผลิตภัณฑ์จะถูกเน้น

คุณจะสังเกตเห็นว่าเป็นแท็ก span ที่มีแอตทริบิวต์ id ตั้งค่าเป็น "productTitle"

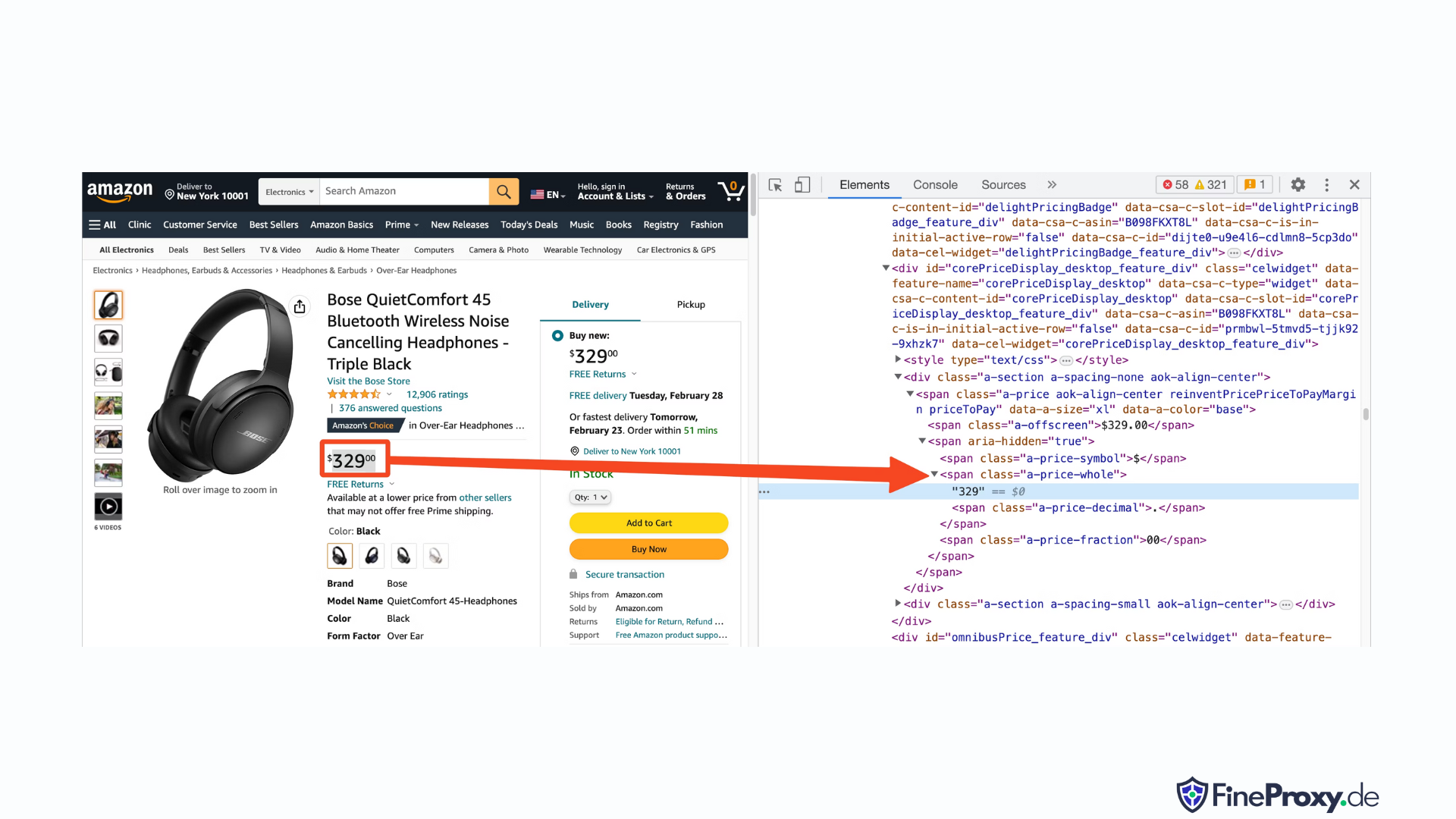

ในทำนองเดียวกัน ให้คลิกขวาที่ราคาและเลือกตรวจสอบเพื่อดูมาร์กอัป HTML ของราคา

ส่วนประกอบดอลลาร์ของราคาอยู่ในแท็กสแปนที่มีคลาส "a-price-whole" ในขณะที่ส่วนประกอบเซนต์อยู่ในแท็กสแปนอื่นที่มีคลาส "a-price-fraction"

คุณยังสามารถค้นหาการให้คะแนน รูปภาพ และคำอธิบายได้ในลักษณะเดียวกัน

เมื่อคุณรวบรวมข้อมูลนี้แล้ว ให้เพิ่มบรรทัดต่อไปนี้ในโค้ดที่มีอยู่:

response = requests.get(url, headers=custom_headers)

soup = BeautifulSoup(response.text, 'lxml')Beautiful Soup เสนอวิธีการที่แตกต่างในการเลือกแท็กโดยใช้วิธีการค้นหา นอกจากนี้ยังรองรับตัวเลือก CSS เป็นทางเลือกอีกด้วย คุณสามารถใช้วิธีใดวิธีหนึ่งเพื่อให้ได้ผลลัพธ์เดียวกัน ในบทช่วยสอนนี้ เราจะใช้ตัวเลือก CSS ซึ่งเป็นวิธีการสากลในการเลือกองค์ประกอบ ตัวเลือก CSS เข้ากันได้กับเครื่องมือขูดเว็บเกือบทั้งหมดสำหรับการแยกข้อมูลผลิตภัณฑ์ของ Amazon

ตอนนี้คุณก็พร้อมที่จะใช้วัตถุ Soup เพื่อสืบค้นข้อมูลเฉพาะแล้ว

การแยกชื่อผลิตภัณฑ์

พบชื่อหรือชื่อผลิตภัณฑ์ในองค์ประกอบ span ที่มีรหัส 'productTitle' การเลือกองค์ประกอบโดยใช้รหัสเฉพาะนั้นทำได้ง่าย

พิจารณาโค้ดต่อไปนี้เป็นตัวอย่าง:

title_element = soup.select_one('#productTitle') เราส่งตัวเลือก CSS ไปยังเมธอด select_one ซึ่งจะส่งคืนอินสแตนซ์องค์ประกอบ

หากต้องการดึงข้อมูลจากข้อความ ให้ใช้แอตทริบิวต์ข้อความ

title = title_element.textเมื่อพิมพ์ คุณอาจสังเกตเห็นช่องว่างสีขาวเล็กน้อย เมื่อต้องการแก้ไขปัญหานี้ ให้เพิ่มการเรียกใช้ฟังก์ชัน .strip() ดังนี้:

title = title_element.text.strip()การแยกการให้คะแนนผลิตภัณฑ์

การได้รับการจัดอันดับผลิตภัณฑ์ของ Amazon ต้องใช้ความพยายามเพิ่มเติม

ขั้นแรก สร้างตัวเลือกสำหรับการให้คะแนน:

#acrPopoverจากนั้น ใช้คำสั่งต่อไปนี้เพื่อเลือกองค์ประกอบที่มีการจัดอันดับ:

rating_element = soup.select_one('#acrPopover')โปรดทราบว่าค่าการจัดอันดับที่แท้จริงจะพบได้ในแอตทริบิวต์ชื่อ:

rating_text = rating_element.attrs.get('title')

print(rating_text)

# prints '4.6 out of 5 stars'สุดท้าย ใช้วิธีการแทนที่เพื่อให้ได้คะแนนตัวเลข:

rating = rating_text.replace('out of 5 stars', '')สกัดราคาสินค้า

ราคาผลิตภัณฑ์สามารถพบได้ในสองตำแหน่ง — ใต้ชื่อผลิตภัณฑ์และภายในกล่องซื้อทันที

แท็กเหล่านี้สามารถใช้เพื่อขูดราคาผลิตภัณฑ์ของ Amazon ได้

สร้างตัวเลือก CSS สำหรับราคา:

#price_inside_buyboxส่งตัวเลือก CSS นี้ไปยังเมธอด select_one ของ BeautifulSoup ดังนี้:

price_element = soup.select_one('#price_inside_buybox')ตอนนี้คุณสามารถพิมพ์ราคา:

print(price_element.text)กำลังแยกรูปภาพ

หากต้องการคัดลอกรูปภาพเริ่มต้น ให้ใช้ตัวเลือก CSS #landingImage ด้วยข้อมูลนี้ คุณสามารถเขียนบรรทัดโค้ดต่อไปนี้เพื่อรับ URL รูปภาพจากแอตทริบิวต์ src:

image_element = soup.select_one('#landingImage')

image = image_element.attrs.get('src')การแยกรายละเอียดสินค้า

ขั้นตอนต่อไปในการดึงข้อมูลผลิตภัณฑ์ของ Amazon คือการได้รับคำอธิบายผลิตภัณฑ์

กระบวนการยังคงสอดคล้องกัน — สร้างตัวเลือก CSS และใช้เมธอด select_one

ตัวเลือก CSS สำหรับคำอธิบายคือ:

#productDescriptionสิ่งนี้ทำให้เราสามารถแยกองค์ประกอบได้ดังนี้:

description_element = soup.select_one('#productDescription')

print(description_element.text)การจัดการรายการสินค้า

เราได้สำรวจข้อมูลผลิตภัณฑ์แบบคัดลอกแล้ว แต่คุณจะต้องเริ่มต้นด้วยรายการผลิตภัณฑ์หรือหน้าหมวดหมู่เพื่อเข้าถึงข้อมูลผลิตภัณฑ์

ตัวอย่างเช่น, https://www.amazon.com/b?node=12097479011 เป็นหน้าหมวดหมู่หูฟังแบบครอบหู

หากคุณตรวจสอบหน้านี้ คุณจะเห็นว่าผลิตภัณฑ์ทั้งหมดอยู่ภายใน div ซึ่งมีแอตทริบิวต์เฉพาะ [data-asin] ภายใน div นั้น ลิงก์ผลิตภัณฑ์ทั้งหมดจะอยู่ในแท็ก h2

ด้วยข้อมูลนี้ ตัวเลือก CSS คือ:

[data-asin] h2 aคุณสามารถอ่านแอตทริบิวต์ href ของตัวเลือกนี้และเรียกใช้การวนซ้ำได้ อย่างไรก็ตาม โปรดจำไว้ว่าลิงก์จะสัมพันธ์กัน คุณจะต้องใช้วิธี urljoin เพื่อแยกวิเคราะห์ลิงก์เหล่านี้

from urllib.parse import urljoin

...

def parse_listing(listing_url):

…

link_elements = soup_search.select("[data-asin] h2 a")

page_data = []

for link in link_elements:

full_url = urljoin(search_url, link.attrs.get("href"))

product_info = get_product_info(full_url)

page_data.append(product_info)การจัดการการแบ่งหน้า

ลิงก์ไปยังหน้าถัดไปอยู่ในลิงก์ที่มีข้อความ "ถัดไป" คุณสามารถค้นหาลิงค์นี้โดยใช้ตัวดำเนินการบรรจุของ CSS ดังนี้:

next_page_el = soup.select_one('a:contains("Next")')

if next_page_el:

next_page_url = next_page_el.attrs.get('href')

next_page_url = urljoin(listing_url, next_page_url)การส่งออกข้อมูล Amazon

ข้อมูลที่คัดลอกมาจะถูกส่งกลับเป็นพจนานุกรมโดยเจตนา คุณสามารถสร้างรายการที่มีผลิตภัณฑ์ที่คัดลอกมาทั้งหมดได้

def parse_listing(listing_url):

...

page_data = [] for link in link_elements:

...

product_info = get_product_info(full_url)

page_data.append(product_info)จากนั้นคุณสามารถใช้ page_data นี้เพื่อสร้างวัตถุ Pandas DataFrame:

df = pd.DataFrame(page_data)

df.to_csv('headphones.csv', index = False)วิธีขูดหลายหน้าใน Amazon

การคัดลอกหลายหน้าใน Amazon สามารถเพิ่มประสิทธิภาพของโปรเจ็กต์การคัดลอกเว็บของคุณได้โดยการจัดเตรียมชุดข้อมูลที่กว้างขึ้นเพื่อวิเคราะห์ เมื่อกำหนดเป้าหมายหลายหน้า คุณจะต้องพิจารณาการแบ่งหน้า ซึ่งเป็นกระบวนการแบ่งเนื้อหาออกเป็นหลายหน้า

นี่ 6 ประเด็นสำคัญที่ควรคำนึงถึง เมื่อขูดหลายหน้าใน Amazon:

- ระบุรูปแบบการแบ่งหน้า: ขั้นแรก วิเคราะห์โครงสร้าง URL ของหมวดหมู่หรือหน้าผลการค้นหาเพื่อทำความเข้าใจว่า Amazon แบ่งหน้าเนื้อหาอย่างไร นี่อาจเป็นพารามิเตอร์การค้นหา (เช่น “?page=2”) หรือตัวระบุเฉพาะที่ฝังอยู่ภายใน URL

- แยกลิงก์หน้า "ถัดไป": ค้นหาองค์ประกอบ (โดยปกติจะเป็นแท็ก Anchor) ที่มีลิงก์ไปยังหน้าถัดไป ใช้ตัวเลือก CSS ที่เหมาะสมหรือวิธี Beautiful Soup เพื่อแยกแอตทริบิวต์ href ขององค์ประกอบนี้ ซึ่งเป็น URL สำหรับหน้าถัดไป

- แปลง URL ที่เกี่ยวข้องเป็น URL ที่สมบูรณ์: เนื่องจาก URL ที่แยกออกมาอาจจะสัมพันธ์กัน ให้ใช้

urljoinฟังก์ชั่นจากurllib.parseไลบรารีเพื่อแปลงเป็น URL ที่สมบูรณ์ - สร้างวง: ใช้การวนซ้ำที่วนซ้ำผ่านหน้าต่างๆ โดยดึงข้อมูลที่ต้องการออกจากแต่ละหน้า การวนซ้ำควรดำเนินต่อไปจนกว่าจะไม่มีหน้าเหลืออีกต่อไป ซึ่งสามารถกำหนดได้โดยการตรวจสอบว่าลิงก์หน้า "ถัดไป" มีอยู่ในหน้าปัจจุบันหรือไม่

- เพิ่มความล่าช้าระหว่างคำขอ: เพื่อหลีกเลี่ยงไม่ให้เซิร์ฟเวอร์ของ Amazon ล้นหลามหรือกระตุ้นมาตรการต่อต้านบอท ให้แนะนำความล่าช้าระหว่างคำขอที่ใช้

time.sleep()ฟังก์ชั่นจากtimeห้องสมุด. ปรับระยะเวลาการหน่วงเวลาเพื่อจำลองพฤติกรรมการท่องเว็บของมนุษย์ - การจัดการ CAPTCHA และบล็อก: หากคุณพบ CAPTCHA หรือการบล็อก IP ในขณะที่คัดลอกหลายหน้า ให้พิจารณาใช้พรอกซีเพื่อหมุนเวียนที่อยู่ IP หรือเครื่องมือและบริการการคัดลอกเฉพาะที่สามารถจัดการกับความท้าทายเหล่านี้ได้โดยอัตโนมัติ

ด้านล่างนี้ คุณจะพบวิดีโอแนะนำการใช้งาน YouTube ที่ครอบคลุมซึ่งจะแนะนำคุณตลอดกระบวนการดึงข้อมูลจากหลายหน้าบนเว็บไซต์ของ Amazon บทช่วยสอนนี้จะเจาะลึกเข้าไปในโลกแห่งการขูดเว็บ โดยเน้นไปที่เทคนิคที่จะช่วยให้คุณสามารถรวบรวมข้อมูลอันมีค่าจากเพจ Amazon จำนวนมากได้อย่างมีประสิทธิภาพและประสิทธิผล

ตลอดบทช่วยสอน ผู้นำเสนอสาธิตการใช้เครื่องมือและไลบรารีที่จำเป็น เช่น Python, BeautifulSoup และคำขอ พร้อมทั้งเน้นแนวทางปฏิบัติที่ดีที่สุดเพื่อหลีกเลี่ยงการถูกบล็อกหรือตรวจพบโดยกลไกต่อต้านบอทของ Amazon วิดีโอครอบคลุมหัวข้อที่สำคัญ เช่น การจัดการการแบ่งหน้า การจัดการขีดจำกัดอัตรา และการเลียนแบบพฤติกรรมการท่องเว็บที่เหมือนกับมนุษย์

นอกเหนือจากคำแนะนำทีละขั้นตอนที่ให้ไว้ในวิดีโอแล้ว บทช่วยสอนยังแบ่งปันเคล็ดลับและเทคนิคที่เป็นประโยชน์เพื่อเพิ่มประสิทธิภาพประสบการณ์การขูดเว็บของคุณ ซึ่งรวมถึงการใช้พร็อกซีเพื่อหลีกเลี่ยงข้อจำกัด IP การสุ่ม User-Agent และส่วนหัวของคำขอ และการดำเนินการจัดการข้อผิดพลาดที่เหมาะสมเพื่อให้แน่ใจว่ากระบวนการขูดข้อมูลจะราบรื่นและไม่สะดุด

การขูด Amazon: คำถามที่พบบ่อย

เมื่อพูดถึงการดึงข้อมูลจาก Amazon ซึ่งเป็นแพลตฟอร์มอีคอมเมิร์ซยอดนิยม มีบางสิ่งที่ต้องคำนึงถึง เรามาเจาะลึกคำถามที่พบบ่อยที่เกี่ยวข้องกับการคัดลอกข้อมูล Amazon กันดีกว่า

1. การขูดอเมซอนเป็นเรื่องถูกกฎหมายหรือไม่

การคัดลอกข้อมูลที่เปิดเผยต่อสาธารณะจากอินเทอร์เน็ตนั้นถูกกฎหมาย และรวมถึงการคัดลอก Amazon ด้วย คุณสามารถขูดข้อมูลได้อย่างถูกกฎหมาย เช่น รายละเอียดสินค้า คำอธิบาย คะแนน และราคา อย่างไรก็ตาม เมื่อขูดรีวิวสินค้า คุณควรระมัดระวังกับข้อมูลส่วนบุคคลและการคุ้มครองลิขสิทธิ์ ตัวอย่างเช่น ชื่อและรูปประจำตัวของผู้ตรวจสอบอาจถือเป็นข้อมูลส่วนบุคคล ในขณะที่ข้อความบทวิจารณ์อาจมีการคุ้มครองลิขสิทธิ์ ใช้ความระมัดระวังเสมอและขอคำแนะนำทางกฎหมายเมื่อคัดลอกข้อมูลดังกล่าว

2. Amazon อนุญาตให้ทำการขูดหรือไม่?

แม้ว่าการคัดลอกข้อมูลที่เปิดเผยต่อสาธารณะนั้นถูกกฎหมาย แต่บางครั้ง Amazon ก็มีมาตรการป้องกันการคัดลอก มาตรการเหล่านี้รวมถึงการร้องขอการจำกัดอัตรา การห้ามที่อยู่ IP และการใช้ลายนิ้วมือของเบราว์เซอร์เพื่อตรวจจับบอทที่คัดลอกมา โดยปกติแล้ว Amazon จะบล็อก Web Scraping ด้วยโค้ดตอบกลับสถานะความสำเร็จ 200 OK และกำหนดให้คุณส่ง CAPTCHA หรือแสดงข้อความ HTTP Error 503 Service Unavailable เพื่อติดต่อฝ่ายขายสำหรับ API แบบชำระเงิน

มีวิธีหลีกเลี่ยงมาตรการเหล่านี้ได้หลายวิธี แต่การขูดเว็บอย่างมีจริยธรรมสามารถช่วยหลีกเลี่ยงการกระตุ้นให้เกิดมาตรการเหล่านี้ได้ตั้งแต่แรก การขูดเว็บอย่างมีจริยธรรมเกี่ยวข้องกับการจำกัดความถี่ของคำขอ การใช้ตัวแทนผู้ใช้ที่เหมาะสม และการหลีกเลี่ยงการขูดมากเกินไปซึ่งอาจส่งผลกระทบต่อประสิทธิภาพของเว็บไซต์ การขูดรีดอย่างมีจริยธรรม คุณสามารถลดความเสี่ยงที่จะถูกแบนหรือเผชิญกับผลทางกฎหมาย ในขณะที่ยังคงดึงข้อมูลที่เป็นประโยชน์จาก Amazon ได้

3. การขูดข้อมูล Amazon มีจริยธรรมหรือไม่

การขูดอย่างมีจริยธรรมเกี่ยวข้องกับการเคารพเว็บไซต์เป้าหมาย แม้ว่าจะไม่น่าเป็นไปได้ที่คุณจะโหลดเว็บไซต์ Amazon มากเกินไปด้วยคำขอมากเกินไป แต่คุณยังคงควรปฏิบัติตามแนวทางการคัดลอกอย่างมีจริยธรรม การขูดอย่างมีจริยธรรมสามารถลดความเสี่ยงในการเผชิญกับปัญหาทางกฎหมายหรือจัดการกับมาตรการป้องกันการขูด

4. ฉันจะหลีกเลี่ยงการถูกแบนขณะขูด Amazon ได้อย่างไร?

เพื่อหลีกเลี่ยงการถูกแบนเมื่อทำการคัดลอก Amazon คุณควรจำกัดอัตราคำขอของคุณ หลีกเลี่ยงการคัดลอกในช่วงชั่วโมงเร่งด่วน ใช้การหมุนเวียนพร็อกซีอัจฉริยะ และใช้ตัวแทนผู้ใช้และส่วนหัวที่เหมาะสมเพื่อหลีกเลี่ยงการตรวจจับ นอกจากนี้ ให้แยกเฉพาะข้อมูลที่คุณต้องการและใช้เครื่องมือการคัดลอกของบุคคลที่สามหรือไลบรารีการคัดลอก

5. อะไรคือความเสี่ยงของการขูดอเมซอน?

การคัดลอกข้อมูลของ Amazon มีความเสี่ยงที่อาจเกิดขึ้น เช่น การดำเนินการทางกฎหมายและการระงับบัญชี Amazon ใช้มาตรการต่อต้านบอทเพื่อตรวจจับและป้องกันการขูดข้อมูล รวมถึงการแบนที่อยู่ IP การจำกัดอัตรา และการพิมพ์ลายนิ้วมือของเบราว์เซอร์ อย่างไรก็ตาม คุณสามารถลดความเสี่ยงเหล่านี้ได้โดยการปฏิบัติตามหลักจริยธรรม

บทสรุป

เมื่อเราออกมาจากเขาวงกตอันน่าหลงใหลของการขูดเว็บของ Amazon ก็ถึงเวลาที่จะใช้เวลาสักครู่เพื่อชื่นชมความรู้และทักษะอันล้ำค่าที่เรารวบรวมมาจากการเดินทางอันน่าตื่นเต้นนี้ ด้วย ProxyCompass เป็นแนวทางที่เชื่อถือได้ คุณจะประสบความสำเร็จในการผ่านขั้นตอนต่างๆ ของการดึงข้อมูลอันล้ำค่าจากบริษัทค้าปลีกยักษ์ใหญ่ เมื่อคุณออกไปผจญภัยและใช้ความเชี่ยวชาญที่ค้นพบใหม่อย่างมีชั้นเชิง จำไว้ว่าป่าดิจิทัลไม่เคยหยุดพัฒนา

อยากรู้อยากเห็น ลับคมมีดขูดเว็บของคุณต่อไป และพิชิตภูมิทัศน์ของการดึงข้อมูลที่เปลี่ยนแปลงตลอดเวลา จนกว่าการสำรวจที่กล้าหาญครั้งถัดไปของเรา นักสำรวจผู้กล้าหาญ ขอให้ภารกิจที่ขับเคลื่อนด้วยข้อมูลของคุณประสบผลสำเร็จและคุ้มค่า!